隨著人工智能技術的迅猛發(fā)展和廣泛應用,其帶來的安全、倫理與治理挑戰(zhàn)日益凸顯。一個健全、前瞻的人工智能安全治理體系,已成為確保技術健康、可持續(xù)、負責任發(fā)展的關鍵。在這一體系中,基礎軟件開發(fā)作為整個AI技術棧的基石,其安全性與可靠性直接決定了上層應用乃至整個生態(tài)的穩(wěn)健程度。因此,構建一個以基礎軟件為核心的人工智能安全一體化治理框架,具有至關重要的戰(zhàn)略意義。

一、 框架的核心目標與原則

人工智能安全一體化治理框架的核心目標,是在促進技術創(chuàng)新的系統(tǒng)性地識別、評估、防范和應對AI全生命周期中的各類風險,確保AI系統(tǒng)的安全性、可靠性、公平性、可解釋性及隱私保護。圍繞基礎軟件開發(fā),該框架遵循以下核心原則:

- 安全與可信原則: 將安全與可信設計(Security and Trust by Design)內(nèi)嵌于基礎軟件的架構、編碼、測試和部署全流程,而非事后補救。

- 責任共擔原則: 明確基礎軟件開發(fā)者、開源社區(qū)、集成商、部署方及最終用戶等各方的安全責任與義務,形成協(xié)同治理合力。

- 透明與可審計原則: 提升基礎軟件(特別是核心算法庫、框架)的透明度,建立代碼、數(shù)據(jù)流向、模型行為的可審計機制。

- 動態(tài)適應原則: 治理框架需具備足夠的靈活性和適應性,能夠跟上AI技術的快速迭代和新型威脅的演變。

- 隱私與數(shù)據(jù)安全原則: 在基礎軟件層面強化數(shù)據(jù)訪問控制、加密、脫敏和生命周期管理能力。

二、 圍繞基礎軟件開發(fā)的一體化治理層級

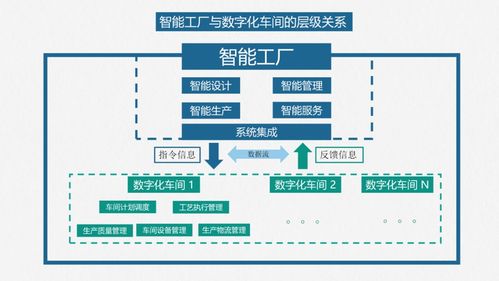

該框架可構建為自上而下、層層遞進的四個治理層級,共同作用于AI基礎軟件的開發(fā)與運營。

第一層:戰(zhàn)略與法規(guī)層

此層為框架提供頂層設計與合規(guī)依據(jù)。包括:

- 國家與行業(yè)戰(zhàn)略: 制定AI安全發(fā)展的國家戰(zhàn)略,明確基礎軟件安全的優(yōu)先方向和支持政策。

- 法律法規(guī)與標準: 出臺針對AI基礎軟件安全、開源合規(guī)、供應鏈安全的法律法規(guī)。推動建立涵蓋代碼安全、數(shù)據(jù)安全、模型安全、接口安全的行業(yè)與技術標準體系。

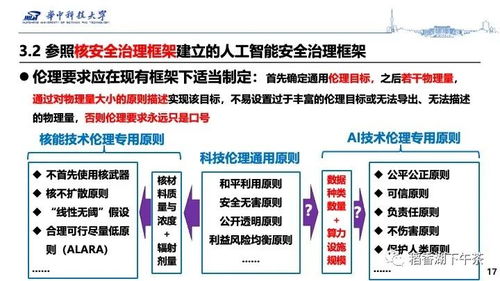

- 倫理準則: 將公平、非歧視、可控等倫理要求轉化為基礎軟件開發(fā)的約束性指標。

第二層:組織與流程層

此層將戰(zhàn)略與法規(guī)要求轉化為具體開發(fā)實踐。包括:

- 安全開發(fā)生命周期(SDLC for AI): 為AI基礎軟件開發(fā)定制安全開發(fā)生命周期,在需求分析、設計、編碼、測試、發(fā)布、維護各階段嵌入安全檢查點。

- 供應鏈安全管理: 建立對第三方庫、開源組件、預訓練模型的嚴格引入審核、持續(xù)監(jiān)控和漏洞響應機制,繪制軟件物料清單(SBOM)。

- 漏洞管理與應急響應: 建立專門針對AI基礎軟件(如框架漏洞、算法后門、數(shù)據(jù)污染)的漏洞披露、評估、修復和應急響應流程與團隊。

- 開發(fā)者教育與認證: 對基礎軟件開發(fā)者進行AI安全專項培訓與能力認證,提升整體安全開發(fā)意識與技能。

第三層:技術與工具層

此層提供實現(xiàn)安全目標的具體技術手段與工具鏈。包括:

- 安全編碼與審計工具: 集成適用于AI代碼(如Python, CUDA)的靜態(tài)/動態(tài)代碼分析工具,檢測安全漏洞與不良模式。

- 數(shù)據(jù)安全與隱私增強技術(PETs): 在基礎軟件中集成差分隱私、聯(lián)邦學習、同態(tài)加密等技術的底層支持,實現(xiàn)數(shù)據(jù)“可用不可見”。

- 模型安全測試工具: 開發(fā)用于測試基礎模型及算法魯棒性(對抗攻擊)、公平性、可解釋性的專用工具包。

- 可信執(zhí)行環(huán)境(TEE): 在硬件和基礎軟件層面支持TEE,保障關鍵代碼與數(shù)據(jù)在運行時的機密性和完整性。

- 監(jiān)控與可觀測性工具: 在基礎軟件中內(nèi)置運行時行為監(jiān)控、日志審計和異常檢測能力。

第四層:驗證與監(jiān)督層

此層確保治理措施的有效性和持續(xù)性。包括:

- 安全測評與認證: 建立獨立的第三方AI基礎軟件安全測評體系,開展安全等級認證。

- 持續(xù)合規(guī)監(jiān)控: 利用自動化工具對已部署的基礎軟件進行持續(xù)合規(guī)性檢查與風險掃描。

- 審計與問責機制: 定期對基礎軟件開發(fā)流程、供應鏈、安全事件進行內(nèi)部與外部審計,并建立清晰的責任追溯與問責機制。

- 社區(qū)與行業(yè)共治: 鼓勵開源社區(qū)建立安全治理規(guī)范,通過行業(yè)聯(lián)盟共享威脅情報和最佳實踐。

三、 關鍵實施路徑

- 優(yōu)先領域突破: 首先聚焦于應用最廣泛、風險最集中的基礎軟件領域,如深度學習框架(TensorFlow, PyTorch等)、大規(guī)模預訓練模型基礎庫、關鍵AI編譯器與運行時,率先建立治理示范。

- 產(chǎn)學研用協(xié)同: 聯(lián)合頂尖學術機構、領先科技企業(yè)、開源社區(qū)和關鍵行業(yè)用戶,共同研發(fā)治理技術、制定標準、開展試點。

- 國際對話與合作: 積極參與全球AI安全治理對話,在基礎軟件安全標準、漏洞披露、倫理準則等方面尋求國際共識與合作,應對跨國性風險。

- 迭代優(yōu)化: 治理框架本身應作為一個“活”的系統(tǒng),根據(jù)技術發(fā)展、威脅態(tài)勢和實踐反饋進行定期評估與迭代更新。

結論

人工智能安全一體化治理是一項復雜而緊迫的系統(tǒng)工程。將治理的關口前移,牢牢抓住基礎軟件開發(fā)這一源頭環(huán)節(jié),構建涵蓋戰(zhàn)略、組織、技術、監(jiān)督的多層次治理框架,是筑牢AI安全防線的根本之策。只有確保“地基”的堅實與可信,才能支撐起人工智能這座宏偉大廈的穩(wěn)定、繁榮與向善發(fā)展,真正釋放其造福社會的巨大潛能。